Spring Cloud 入门教程9、服务限流/API限流(Zuul+RateLimiter)

一、前言

1、什么是RateLimiter、Spring Cloud Zuul RateLimiter?

RateLimiter是Google开源的实现了令牌桶算法的限流工具(速率限制器)。http://ifeve.com/guava-ratelimiter/

Spring Cloud Zuul RateLimiter结合Zuul对RateLimiter进行了封装,通过实现ZuulFilter提供了服务限流功能

| 限流粒度/类型 | 说明 |

|---|---|

| Authenticated User | 针对请求的用户进行限流 |

| Request Origin | 针对请求的Origin进行限流 |

| URL | 针对URL/接口进行限流 |

| Service | 针对服务进行限流,如果没有配置限流类型,则此类型生效 |

https://github.com/marcosbarbero/spring-cloud-zuul-ratelimit

2、本篇主要内容

- 服务限流配置示例与说明

- URL限流配置示例与说明

- Zull集群服务限流说明(+Redis)

- Spring Cloud Zuul RateLimiter参数介绍

3、本篇环境信息

| 框架 | 版本 |

|---|---|

| Spring Boot | 2.0.0.RELEASE |

| Spring Cloud | Finchley.RELEASE |

| Zuul | 1.3.1 |

| JDK | 1.8.x |

4、准备工作

参考上一篇:https://ken.io/note/spring-cloud-zuul-quickstart

基于源码:https://github.com/ken-io/springcloud-course/tree/master/chapter-08

- 准备Eureka Server、服务提供者

启动Eureka Server: http://localhost:8800

启动Test Service:http://localhost:8602

二、服务限流(Zuul+RateLimiter)

基于上一篇中zuul项目的源码进行修改即可:https://github.com/ken-io/springcloud-course/tree/master/chapter-08/zuul

- 引入spring-cloud-zuul-ratelimit

<dependency>

<groupId>com.marcosbarbero.cloud</groupId>

<artifactId>spring-cloud-zuul-ratelimit</artifactId>

<version>2.0.4.RELEASE</version>

</dependency>

1、默认服务限流策略

- 修改 application.yml 配置限流策略

zuul:

ratelimit:

enabled: true

default-policy:

limit: 1

quota: 2

refresh-interval: 3

以上配置表示启用限流策略,并且所有服务在3秒内只能有1次请求且所有请求时间总和不得超过2秒

- 限流测试

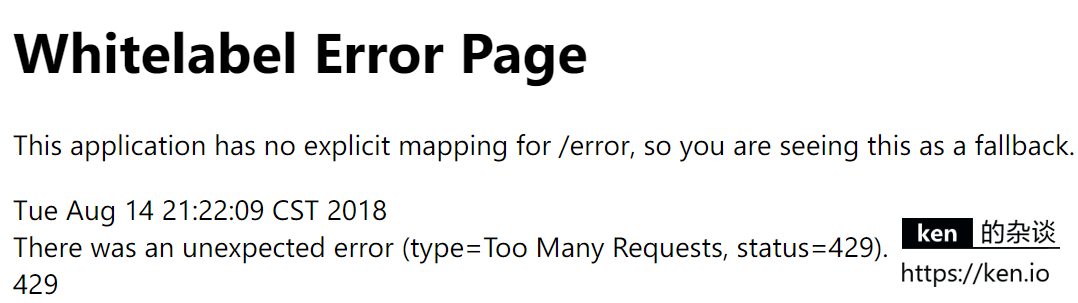

启动zuul项目,然后访问 http://localhost:8888/testservice?token=ken

3秒内访问两次,就会看到错误页面

错误信息:type=Too Many Requests, status=429

这说明3秒内的>1次的访问已经被限流策略挡掉

2、为指定服务单独配置限流策略

- 修改 application.yml 配置限流策略

zuul:

ratelimit:

enabled: true

default-policy:

limit: 1

quota: 1

refresh-interval: 3

policies:

testservice:

limit: 10

quota: 50

refresh-interval: 60

以上配置单独为testservice配置了限流策略。60秒内访问次数不得查过10次且访问时间这不得超过50秒。

虽然我们也同时配置了默认限流策略,而且默认限流策略比testservice的限流策略还要更严格,但是这个限流并不会冲突。因为一旦我们为某个服务单独配置了限流策略,那么只有这个单独配置的限流策略会对该服务生效。

3、基于URL的限流策略

- 修改 application.yml 配置限流策略

zuul:

ratelimit:

enabled: true

default-policy:

limit: 1

quota: 1

refresh-interval: 3

policies:

testservice:

limit: 10

quota: 50

refresh-interval: 60

type: url

以上配置只是在testservice的策略上增加了type参数的设置。(当然也可以在默认策略加这个参数)。

那么这个策略就变成了:每个Url60秒内访问次数不得超过10次且总计访问时间这不得超过50秒。

- 访问测试

启动zuul项目,然后访问: http://localhost:8888/testservice?token=ken

达到限流阈值后,访问:

http://localhost:8888/testservice/plus?token=ken&numA=1&numB=2

依然可以正常访问。

另外,需要值得注意的是,?后面的参数是不会作为限流的key的。

http://localhost:8888/testservice?token=ken , http://localhost:8888/testservice?token=ken.io 会被作为同一个url进行限流

如果zuul-ratelimiter的限流粒度/方式不能满足你的需求,你可以选择自定义ZuulFilter集成RateLimiter去做限流。

三、Zuul集群服务限流(Zuul+RateLimiter+Redis)

RateLimiter的限流数据是默认以ConcurrentHashMap方式存储在内存中的,

当我们部署了Zuul集群的时候,就会影响我们的限流策略了。我们可以将限流数据存储在Redis中,这样就可以集中记录各个Zuul节点的限流数据,来保证限流的准确性。

1、部署Reids Server

参考:https://ken.io/note/centos7-redis4-setup

2、引入 Spring Data Redis

<dependency>

<groupId>org.springframework.boot</groupId>

<artifactId>spring-boot-starter-data-redis</artifactId>

<version>2.0.4.RELEASE</version>

</dependency>

3、配置Redis连接

修改application.yml

spring:

redis:

host: 192.168.88.11

port: 6379

4、配置RateLimiter数据存储方式

zuul:

ratelimit:

enabled: true

repository: redis

default-policy:

limit: 1

quota: 1

refresh-interval: 3

policies:

testservice:

limit: 10

quota: 50

refresh-interval: 60

type: url

四、备注

Zuul-RateLimiter参数说明

- Zuul-RateLimiter基本配置项

| 配置项 | 可选值 | 说明 |

|---|---|---|

| enabled | true/false | 是否启用限流 |

| behind-proxy | true/false | 翻了源码,没发现有使用。。。作者也没说明。。。 |

| key-prefix | String | 限流key前缀 |

| repository | CONSUL, REDIS, JPA, BUCKET4J_JCACHE, BUCKET4J_HAZELCAST, BUCKET4J_INFINISPAN, BUCKET4J_IGNITE, IN_MEMORY | 限流数据的存储方式,默认是:IN_MEMORY |

| default-policy | — | 默认策略 |

| policies | — | 自定义策略 |

| postFilterOrder | — | postFilter过滤顺序 |

| preFilterOrder | — | preFilter过滤顺序 |

- Policy限流策略配置项说明

| 项 | 说明 |

|---|---|

| limit | 单位时间内请求次数限制 |

| quota | 单位时间内累计请求时间限制(秒),非必要参数 |

| refresh-interval | 单位时间(秒),默认60秒 |

| type | 限流方式:ORIGIN, USER, URL |

附录

- 本篇代码示例

https://github.com/ken-io/springcloud-course/tree/master/chapter-09

- 本篇参考

https://github.com/marcosbarbero/spring-cloud-zuul-ratelimit